spark单机模式安装部署配置教程

一、安装Spark 的前置条件

1、Java Jdk 安装

2、Hadoop 安装

安装方式,见:mac OS hadoop伪分布安装教程

二、安装scala

1、执行命令:brew install scala,执行完成即可完成 scala 的安装

三、Spark 下载

下载地址:http://spark.apache.org/downloads.html

我们选择版本:spark-3.0.1-bin-hadoop3.2,因为安装的hadoop 版本为 3.2.1

四、安装Spark

1、解压 tar -zxvf spark-3.0.1-bin-hadoop3.2.tgz

2、将目录移到 /usr/local/spark3.0.1 目录下

执行命令 sudo mv /Users/jasongao/Documents/soft/spark-3.0.1-bin-hadoop3.2 /usr/local/spark3.0.1

五、环境变量配置

export SCALA_HOME=/usr/local/Cellar/scala/2.13.1

export PATH=$PATH:$SCALA_HOME/bin

export SPARK_HOME=/usr/local/spark3.0.1

export PATH=$PATH:$SPARK_HOME/bin

.zshrc .bash_profile 两个文件最好都添加一下,mac OS 10.15 以后的版本,有的会切换成 .zshrc 文件

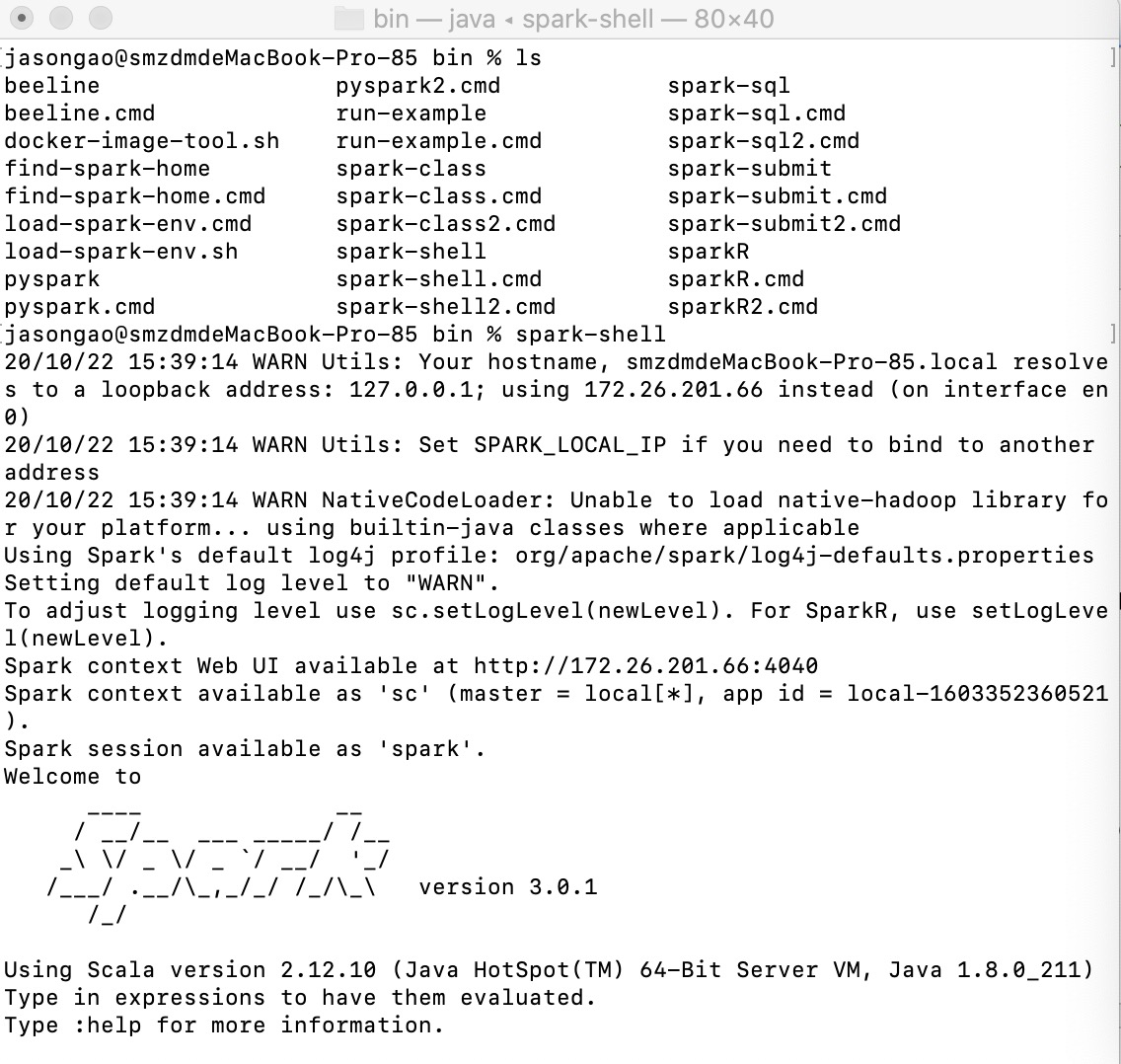

六、启动Spark

1、进入 /usr/local/spark3.0.1/sbin ,执行命令

2、执行 ./start-all.sh,可以在local.out文件下查看相关的启动情况

3、进入/usr/local/spark3.0.1/bin,执行 spark-shell ,即可启动Spark控制台界面

<a href="http://r4.com.cn/art147.aspx">spark单机模式安装部署配置教程</a>